作者:Lina

智东西3月27日美国圣何塞报道,今天早上,英伟达GTC 2018年度大会的最重磅环节——创始人&CEO黄仁勋主题演讲——正式开始。智东西在圣何塞McEnery会议中心现场第一排来报道~

每年的GTC大会上,这位被粉丝们爱称为“老黄”的黑色皮衣爱好者CEO都会带来一场重磅主题演讲,通常来说不仅会发布新型GPU与超算电脑,还会宣布一些AI/VR/自动驾驶等领域重磅合作。

不过,今年的GTC 2018比较神奇,最为重磅的消息选择了在提前秘密发布,而不是在GTC Keynote现场——英伟达重磅宣布,将联合芯片巨头ARM打造IOT设备的AI芯片专用IP,这款机器学习IP集成到Arm的Project Trillium平台上,以实现机器学习,其技术源于英伟达Xavier芯片以及去年开源的DLA深度学习加速器项目。

ARM是全球智能设备第一大主流芯片架构提供商,全球超过90%的智能设备采用了ARM的芯片架构,包括手机、平板、手表、电视、无人机等等。本次ARM牵手英伟达推出专用的IOT设备人工智能IP,将会有助于人工智能在终端设备广泛铺开,使得上亿、甚至数十亿台IOT设备都能够用上低功耗、低成本的AI芯片,使物联网芯片公司能够轻松地将AI集成到它们的设计中,并帮助它们将智能且价格实惠的产品带给全球数十亿的消费者。

NVIDIA副总裁兼自主机器事业部总经理Deepu Talla表示:“推理将成为每个物联网设备的核心能力。我们将与ARM一同推进这一趋势的发展,帮助数百家芯片公司轻松采用深度学习技术。”

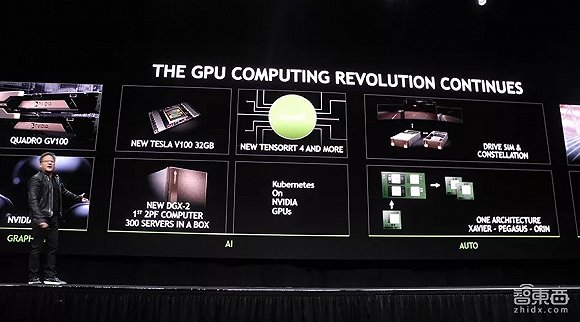

此外,在今天的GTC 2018上,黄仁勋还宣布了英伟达的以下进展:

1、推出光线追踪RTX技术(ray-tracing),能够提供电影级画质的实时渲染,渲染出逼真的反射、折射和阴影画面。这一技术由英伟达在前不久的GDC全球游戏开发者大会上展示过;

2、推出第一款采用Volta架构的Quadro GV100 GPU,由两个GV100连接而成;

3、推出了第一款专用于医疗图像处理的超级电脑Clara;

4、新版Tesla V100内存升为32G,可与旧版无缝换插,支持更多人工智能的工作负载;

5、推出DGX-2超级电脑,采用了最新的NVSwitch链接,最多可同时连接16块Tesla V100 GPU,其速度可以达到DGX-1的10倍,算下来可以每秒下载14000 部电影,售价39.9万美元;

6、推出新版机器学习应用平台TensorRT 4,支持INT8与FP16精度,并与谷歌合作,将其整合进AI开源框架谷歌TensorFlow 1.7中;

7、宣布打造下一代名为DRIVE Orin的自动驾驶芯片,但除了名字外没有透露更多信息;

8、正式推出3D仿真自动驾驶测试平台DRIVE Constellation,这一测试平台英伟达在CES上展示过,能够帮助自动驾驶系统提升“姿势水平”;

9、推出ISAAC机器人仿真训练平台SDK,将训练机器人的技术开放出去;

值得一提的是,智东西去年5月时也对GTC 2017进行了一线深入报道,在去年的CEO主题演讲开场前,英伟达的股价一路飙升至121美元,总市值达到了714亿美元。而在今年开场前一晚,英伟达的股价已经冲到了244美元,总市值超过1479亿美元。在这10个月内,英伟达的股价与市值再次翻倍。

光线追踪(ray-tracing)技术开场

今天一大早,智东西来到了GTC大会现场,准备参加每年GTC的最重磅环节——CEO黄仁勋主题演讲。此时是早上8点,离9点开场还有整整一小时前,但是入口处已经排起了巨长的队伍。

今天,老黄依旧是万年不变的一身黑皮衣+黑裤子开场。

他开场介绍的第一个项目就是英伟达在前不久GDC上发布的NVIDIA RTX光线追踪技术(ray-tracing),这项技术是英伟达耗时10年打造的,能够提供电影级画质的实时渲染,渲染出逼真的反射、折射和阴影画面,几乎与真实世界的照片或视频很难区分开来。现场展示的视频片段就是用光线追踪技术实时渲染的,而且并不需要一个超级强大的超算电脑,只需要一台DGX-Station。

在真实世界中,我们看到的3D物体被光源照亮,且光子可以在到达观看者的眼睛以前从一个物体反弹到另一个物体。光线追踪技术则是反过来,通过从我们的眼睛(观景式照相机)反向追踪光线捕捉这些效果,通过追踪2D视表面上每个像素的光线的路径,并应用到场景的3D模型中。

可想而知,这种技术的计算量非常大,一般渲染复杂的特殊效果可能需要花上几天甚至几周的时间,所以此前该项技术一直仅限于高成本的电影制作中。

不过,目前,随着GPU性能日益强悍,能够支持光线追踪的电脑也越来越多,通过Volta架构的GPU配合英伟达的RTX技术,产品设计师、游戏设计师、建筑师们能够在几秒内即可生成逼真的产品模型。

此外,英伟达还宣布GameWorks SDK 将添加一个光线追踪降噪模块。更新版 GameWorks SDK 即将推出,其中包含光线追踪区域阴影和光线追踪光泽反射。

新版Quadro GV100,首次采用Volta架构

与此同时,英伟达还在现场推出了Quadro GV100 GPU,同时也是同系列产品中第一个采用Volta架构的,因此能够搭载RTX技术的。

Quadro GV100由两个GV100连接而成,一共拥有10240个CUDA核,可达236 TFLOPS Tensor Cores。与此同时,老黄又玩起了“买GPU省钱”的梗——“你买的GPU越多,就越省钱(The more you buy, the more you save.)”,这一个梗再次贯穿了全场。

推出医疗专用超级电脑Clara,日常diss摩尔定律

接着,话锋一转,老黄开始谈起了计算力,我们也进入了GTC的必备环节——diss摩尔定律。

在将近10年的GTC上,每年老黄都会提到同一主题——摩尔定律。在过去30年里,我们受益于摩尔定律,芯片所提供的计算能力每年都高速增长。然而在最近的几年里,摩尔定律开始失灵,芯片发展的速度已经跟不上我们需要的计算力增长速度。

因此,我们需要新定律。

而随着数据量与计算量爆发式地增长,人工智能、GPU、CUDA正在以一种极快的速度崛起,以GPU驱动的人工智能计算已经随处可见,并且渗入到各行各业当中去,教育、娱乐、工业、制造……这也引出了我们下一个话题——医疗。

老黄在现场推出了第一款专用于医疗图像处理的超级电脑Clara,它能够支持CUDA、CUDNN、TensorRT、OGL、以及刚刚提到的RTX技术。

在现场,老黄展示了一个医疗图像实时处理的影像片段。这个段影像是用十几年的超声波老设备拍摄而成,本来只能看到2D的黑白图像。然而当数据传进Clara后,配合人工智能软件,可以在2D图像中分析出3D的腔膛形状(图中红色部分)。因此,医院可以在现有医疗设备上直接接入这台电脑。

目前,英伟达正在和众多医疗厂商合作,除了GE通用电气、三星电子等大厂外,还有像图玛深维、推想科技等AI医疗创业公司。

新品升级:新版Tesla V100、DGX-2超级电脑、TensorRT 4

在去年的GTC 2017上,老黄发布了一款名为Tesla V100的新版GPU,使用Volta架构,采用的是台积电的12nm Finfet工艺,具有5120个CUDA处理内核,16GB内存,能够为训练、推理应用提供120 tensor TFLOPS算力。

今天,老黄宣布,新版Tesla V100将内存升级一倍,达到32GB。

由于这几年间,CNN、RNN、GANs、Deep Q-Learning等算法不断变得复杂,更是对深度学习计算硬件提出了新挑战。因此,新版Tesla V100拥有更大的内存,使得它能够运行更大、更复杂的神经网络,在某些HPC应用上能够提供高于之前16GB版本50%的性能。微软已经宣布采用了新版Tesla V100,能够更快速地训练更加强大的深度神经网络。

此外,英伟达本次还推出的NVSwitch高速互联技术。此前英伟达曾经推出NVLink,支持最多8块GPU高速互联;如今NVSwitch技术可将这个数字翻上一倍,支持最多16块GPU同时互联。每一个GPU都能和另一个GPU进行超低延迟的通讯。

在去年GTC上,英伟达推出了搭载8块Tesla V100的超级电脑DGX-1,今天在GTC 2018现场老黄宣布,推出能够搭载16块新版Tesla V100的超级电脑DGX-2,比DGX-1还要快10倍。

DGX-2能够进行2 PFLOPS的计算,算下来可以每秒下载14000部电影,拥有512GB HBM2,功耗为10kw,350lbs,能够支持更大数据集、更复杂神经网络的计算。售价399000美元,今年Q3上市。

它其中搭载着被老黄称为“世界上最大的GPU”,共有81920个CUDA核,可达2000 TFLOPS Tensor Cores,拥有512GB HBM2。

此外,去年的GTC上,英伟达推出了“英伟达GPU云(NVIDIA GPU Cloud)”,但它不是一个云计算“云”,而是一个能让人轻易地从零开始搭建一个深度学习的项目。今天老黄宣布,AWS、阿里云、DGX、GCP、Oracle Cloud上都开始支持英伟达GPU云了。

而且,从CNN到LSTM再到GANs,现在的深度学习神经网络框架正变得越来越复杂、越来越多样、而且在日新月异地变化着,训练环节变得复杂了,应用(Inference)环节自然也变得非常复杂。

因此,老黄还在现场推出了最新版本的TensorRT——TensorRT 4,这是一款可编程应用平台(Programmable Inference Platform),当你将一个神经网络训练好了之后,可以通过TensorRT可编程平台,简便快捷地将这个训练好了的神经网络部署(Deploy)到英伟达的GPU上。

新版TensorRT 4能够支持INT8和FP16精度运算,能够将数据中心的功耗降低70%。而且,英伟达还与谷歌进行了深度合作,将TensorRT整合进如今最广泛应用的AI开源框架谷歌TensorFlow 1.7中。而且现在还能够加速图像、视频、语言、NLP等AI应用。

同时,老黄还在现场宣布,KUBERNETES现在能够支持GPU了。KUBERNETES能够在主机集群之间提供一个能够自动化部署、可拓展、应用容器可运营的平台,通常结合docker容器工具工作,并且整合多个运行着docker容器的主机集群,不仅能够提供更大的计算力,还能够有更大的容错空间。

打造下一代DRIVE Orin自动驾驶芯片

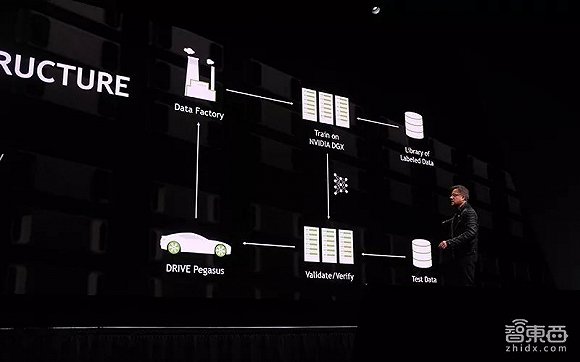

老黄在现场还展示了英伟达感知基础(Perception Infrastructure)项目,这是一个大型的深度学习模型,能够收集并分析不同传感器(如摄像机、雷达等等)得出的距离、天气、雷达感知、高精地图等等不同数据。

在接下来2-3年间,英伟达还将技术研发这一技术,直到最后能够搭载在所有新车上。老黄说,这是我们至今遇到的最为复杂的问题之一。

在现场,老黄还展示了英伟达DRIVE的研发路径,它们都基于同一框架、满足ADSL-D的安全标准、并且性能/功耗比非常高:从DRIVE PX Parker、到DRIVE PX 2、再到DRIVE Xavier、再到DRIVE Pegasus……

老黄说,虽然DRIVE Pegasus已经非常强大了,但是,英伟达还会打造下一代名为DRIVE Orin的芯片,不过现场没有透露更多信息。

推出自动驾驶仿真测试平台DRIVE Constellation

在今年1月的CES上,老黄曾经展示了一个全新的3D自动驾驶仿真测试平台。而今天,老黄正式推出了这款名为DRIVE SIM and Constellation的3D自动驾驶仿真测试平台。

这款平台包括两个部分,先是在云端模拟照片级真实的图像,生成传感器数据(包括摄像头、雷达等)第二部分则包括将这些数据传到英伟达DRIVE Pegasus中,并运行全套自动驾驶软件,以帮助训练该自动驾驶系统提升“姿势水平”。

在实际演示中,英伟达的新仿真平台显得十分强大,不仅有传统一点的实时车导线规划、其他车辆识别,而且对环境的还原相当真实,复杂的光线条件也能够被模拟。测试人员还能够在平台内操纵、变化车辆传感器的探测范围。

另外,这个平台还支持开发人员在虚拟环境中“人为驾驶”一辆车作出各种危险动作来考验测试车,来考验测试车的算法。

会上,老黄还宣布,目前英伟达自动驾驶合作伙伴的数量已经达到了370家,其中包括整车厂、一级供应商、以及200+家创企。

与自动驾驶仿真测试平台相似的,英伟达还在去年推出了专用于机器人的仿真测试平台——ISAAC机器人训练模拟世界。你可以用这个虚拟世界来训练机器人前进、后退、转弯、躲避行人等。

今天,老黄宣布将ISAAC平台的技术开放出去,推出ISAAC SDK。

此外,英伟达此前还推出过一款VR多人交互平台Holodeck。在今天的GTC 2018上,英伟达还展示了一个非常有趣、也非常’黑科技“的DEMO:在Holodeck虚拟世界里远程控制现实世界里的汽车。(看过《黑豹》的同学大概可以理解一下)

上文提到,今年的GTC 2018比较神奇,最为重磅的消息选择了在提前秘密发布,而不是在GTC Keynote现场——英伟达重磅宣布,将联合芯片巨头ARM打造AI芯片专用IP,这款IP属于ARM几年2月公布的Trillium项目的一部分,其技术源于英伟达Xavier芯片以及去年开源的DLA深度学习加速器项目。

英伟达本次宣布同AEM合作,将在数十亿物联网设备上实现深度学习。NVIDIA深度学习加速器IP将集成到Arm的Project Trillium平台中,以便于构建深度学习IoT芯片。

去年,英伟达也正式免费开源了完整版DLA(Deep Learning Accelerator,深度学习加速器),让厂商可以免费下载使用,打造属于自己的低功耗AI芯片(比如IoT芯片)。

今年2月,芯片巨头ARM公布了其人工智能项目Trillium,同时推出两款专用IP,分别为物体检测OD处理器和机器学习ML处理器。

ARM是全球智能设备第一大主流芯片架构提供商,全球超过90%的智能设备采用了ARM的芯片架构,包括手机、平板、手表、电视、无人机等等。而英伟达,作为全球AI浪潮的引领者,能够为人工智能提供强大的计算力,二者一拍即合。

本次ARM牵手英伟达推出专用的IOT设备人工智能IP,将会有助于人工智能在终端设备广泛铺开,使得上亿、甚至数十亿台IOT设备都能够用上低功耗、低成本的AI芯片,使物联网芯片公司能够轻松地将AI集成到它们的设计中,并帮助它们将智能且价格实惠的产品带给全球数十亿的消费者。

NVIDIA副总裁兼自主机器事业部总经理Deepu Talla表示:“推理将成为每个物联网设备的核心能力。我们将与ARM一同推进这一趋势的发展,帮助数百家芯片公司轻松采用深度学习技术。”

结语:更多精彩敬请期待

今年,共有超过8000人来到了GTC 2018现场,150个展位。值得一提的是,英伟达也在推动女性在科技行业中的力量,今年女性占据了GTC 2018总开发者的8%,总参会者的10%,以及11%的演讲者。

每年的GTC上,除了英伟达的各类主业务负责人的交流沟通会议、来自大大小小各类开发者或技术大牛的主题演讲外、还有150家英伟达的合作企业布设展位,以供开发者与媒体参观交流。在接下来的3天里,智东西将继续在圣何塞McEnery会议中心现场为你发来报道,还包括与英伟达CEO黄仁勋及各位高管的交流采访,敬请期待~

上一篇:闪迪发布新一代的400GB UHS-I microSD存储卡

下一篇:加大OLED面板供应 LG电子抢占OLED电视市场份额

推荐阅读最新更新时间:2024-05-03 02:39

人工智能算法(卷2)-受大自然启发的算法

人工智能算法(卷2)-受大自然启发的算法 控制系统计算机辅助设计 — MATLAB语言与应用

控制系统计算机辅助设计 — MATLAB语言与应用

京公网安备 11010802033920号

京公网安备 11010802033920号