当前,随着人工智能/机器学习(AI/ML)的极速兴起,智能技术正被广泛应用于制造业、交通、医疗、教育和金融等各个领域,人工智能将掀起下一次工业革命。

中国作为全球人工智能发展最快的国家之一,正备受瞩目。根据德勤最新发布的统计预测数据显示,2020年全球人工智能市场规模将达到6800亿元人民币,复合增长率(CAGR)达26%。而中国人工智能市场的表现尤为突出,到2020年市场规模预计将达到710亿元人民币,自2015年至2020年,五年间的复合增长率高达44.5%。

近年来,中国正在积极推动人工智能与实体经济的融合,从而实现产业的优化升级。2017年7月,国务院印发了《新一代人工智能发展规划》,这一规划与2015年5月发布的《中国制造2025》共同构成了中国人工智能战略的核心。这份具有里程碑意义的规划,对人工智能发展进行了战略性部署,力争到2030年把中国建设成为世界主要人工智能创新中心。此外,2020年是中国的新基建元年,而人工智能作为一大重点板块,势必成为新基建的核心支撑。

在此背景下, 中国人工智能产业规模在2019年末达到510亿元人民币,其中人工智能企业超过2600家。随着中国加速推进人工智能应用以引领经济增长,这一趋势将推动计算机硬件和软件各方面的快速发展。

Rambus在最新发布的白皮书中探讨了内存带宽对AI/ML的重要作用,特别介绍了HBM2E和GDDR6内存优势和设计注意事项。白皮书还解释了每种内存在整个AI/ML架构中的适用性,以及如何利用Rambus HBM2E和GDDR6接口解决方案来实现一个完整的内存子系统。以下是白皮书的一些重要内容:

AI/ML步入高速发展期

作为AI/ML的关键应用场景,训练与推理能力的发展,从某种程度上代表着人工智能的高速发展。从2012年到2019年,人工智能训练集增长了30万倍,要求人工智能计算机硬件和软件的各个方面都需要不断的快速改进。与此同时,人工智能推理正在网络边缘和广泛的物联网设备中采用,包括在汽车/ADAS中。

支持这一发展速度需要的远不止摩尔定律所能实现的改进,摩尔定律在任何情况下都在放缓,这就要求人工智能计算机硬件和软件的各个方面都需要不断的快速改进。

内存带宽是影响AI发展的关键因素

内存带宽将成为人工智能持续增长的关键焦点领域之一。以先进的驾驶员辅助系统(ADAS)为例,第3级及更高级别系统的复杂数据处理需要超过200 GB/s的内存带宽。这些高带宽是复杂的AI/ML算法的基本需求,在道路上自驾过程中这些算法需要快速执行大量计算并安全地执行实时决策。在第5级,即完全自主驾驶,车辆能够独立地对交通标志和信号的动态环境作出反应,以及准确地预测汽车、卡车、自行车和行人的移动,将需要超过500GB/s的内存带宽。

随着新一代AI/ML加速器和专用芯片的快速发展,新的内存解决方案,如高带宽内存(HBM、HBM2、HBM2E)和GDDR6 SDRAM(GDDR6)渐被采用来提供所需的带宽。

HBM2E和GDDR6助力新一轮人工智能应用浪潮

鉴于AI/ML的需求分流的特性,内存的选择取决于应用:训练还是推理。HBM2E和GDDR6这两种高带宽内存,都可以起到至关重要的作用。

对于训练来说,带宽和容量是至关重要的需求。特别是考虑到训练集的规模正以每3.43个月翻一番的速度增长。此外,在数据中心运行的训练应用程序因电源和空间所致的限制越来越大,因此有一个提供更佳能效和更小尺寸的解决方案是一大加分。考虑到所有这些需求,HBM2E是AI训练硬件的理想内存解决方案。

在推理的情况下,带宽和延迟对于实时操作的需求至关重要。对于人工智能推理这一日益具有挑战性的领域,GDDR6是一个理想的解决方案。建立在成熟的制造工艺基础上,其出色的性价比使其适合广泛的采用。

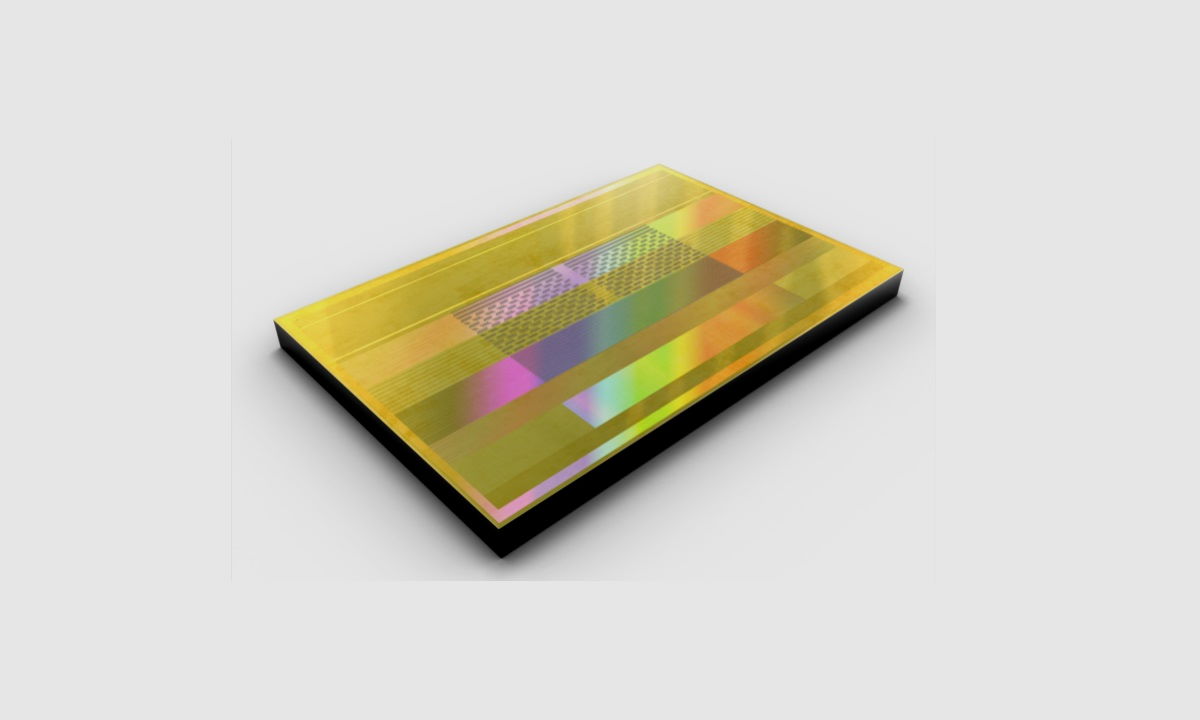

Rambus提供全面且现成的HBM2E和GDDR6内存接口解决方案,可集成到AI/ML训练和推理SoCs中。最近,该公司的 HBM2E内存接口解决方案实现了创纪录的4 Gbps性能。该解决方案由完全集成的PHY和控制器组成,搭配业界最快的,来自SK hynix的3.6Gbps运行速度的HBM2E DRAM,该解决方案可以从单个HBM2E设备提供460 GB/s的带宽。此性能可以满足TB级的带宽需求,针对最苛刻和最先进的AI/ML训练和高性能的加速器计算(HPC)应用而生。

总的来说,训练和推理有其独特的应用需求,可以通过定制内存解决方案来支持。HBM2E是AI训练的理想选择,GDDR6是AI推理的理想选择。设计师可以通过与Rambus合作来克服这些架构中固有的设计挑战,从而实现这些高性能内存的长处。

上一篇:边缘AI是内存技术发展的催化剂

下一篇:新型存储技术CeRAM,FeFET即将登上舞台

推荐阅读最新更新时间:2024-11-16 22:37

JEDEC JESD250-2017 Graphics Double Data Rate (Gddr6) Sgram Standard

JEDEC JESD250-2017 Graphics Double Data Rate (Gddr6) Sgram Standard 电子元器件抗ESD技术讲义

电子元器件抗ESD技术讲义 电子元器件抗ESD技术讲义.rar

电子元器件抗ESD技术讲义.rar 零基础学电子与Arduino:给编程新手的开发板入门指南

零基础学电子与Arduino:给编程新手的开发板入门指南

京公网安备 11010802033920号

京公网安备 11010802033920号